Je me suis aventurée, par le passé, dans le object oriented programming

rendu possible par Microsoft Visual Studio. L'idée directrice en revient

à modulariser le code en termes d'objets-code, ce qui sinplifie les choses

considérablement. Je veux un rectangle pour mon projet, j'en demande un

dans l'interface de codage et tout le code se met en place automatiquement.

Grâce à CC, je comprends que le OOP est en fait issu de la discipline du

Software Engineering. Le problème de fond: des énormes programmes sur

lesquels plusieurs personnes travaillent, mais que personne ne connaît dans son

ensemble. Microsoft Office à lui seul se bâtit sur 14 millions de lignes de code!!

Il y aura des pratiques sécuritaires à suivre, bien sûr. Et on garde toujours des versions

antérieures pour parer l'éventualité d'un bug à l'intérieur d'une mise à jour...

* * *

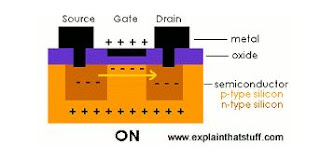

CC# 17 nous présente les circuits intégrés et la fameuse

loi de Moore: l'accélération du nombre de transistors sur une

petite puce de silicone. Et ce M. Gordon Moore mérite d'être plus

connu: il est le fondateur, avec Robert Noyce à qui l'on doit la bonne

idée du silicone, en 1968 de Intel ( de integrated et electronics),

aujourd'hui le fabricant des CPUs de la plupart des ordis.

La première génération d'ordi, entre 1943 et 1960, se fiait à

des composantes discrètes, que l'on devait souder. Avec

éventuellemnt des millions de raccordements, ces ordis remplissaient

des salles.

La deuxième génération a remplacé les tubes à vide par les transistors.

En 1958, Jack St. Clair Kilby (circuit intégré, reconnu par un prix

Nobel en 2000) et Noyce permettent une première miniaturisation.

Mais c'est finalemnt le cicuit imprimé, en 1963, qui sauve la situation.

Plus les composantes deviennent légères, plus les ordis peuvent être

rapides, et ils tirent finalement moins de pouvoir.

(l'Intel 4004, sur 4 bits). Depuis quelques milles transistors par puce, on

passe en 1980 à 30 000, 1 million en 1990, 30 millions en 2000, 1 milliard

en 2010. Ceci requiert des procédures de miniaturisation extrêmes, dont la

conception se fait sur ordi; Apple propose actuellement une puce de 3.3 milliards

de transistors. Effectivement, une quatrième génération.

Peut-on aller plus loin: le photomasque semble avoir ateint ses limites;

et avec des bornes à quelques atomes de distance, les électrons

deviennent passibles d'effectuer des sauts quantiques...

* * *

de l'ordi personnel a testé le pauvre consommateur.

Il se sentait partie prenante de l'aventure, et a

vécu les débuts du système d'exploitation.

Dans CC# 18, on voit comment les fameux drivers (pilotes)

que nous connaissons tous furent la réponse au problème du

concepteur de système d'exploitation qui devait constamment

peaufiner afin d'intégrer tel ou autre périphérique. Le pilote coupe

Et que dire de l'infâme blue screen of death; l'écran bleu des

premiers ordis MS-Dos qui nous annonçaient que plus rien n'allait.

CC nous apprend que c'était voulu. En mettant sur peidUNIX, les

concepteurs n'avaiebt que très peu de mémoire à leur disposition.

Ils ont programmé les crash inévitables!! Dire que tout ce temps,

je me suis sentie coupable...

* * *

Le CC# 19 nous ballade dans l'historique de la mémoire ordinateur.

Bien sûr, c'est un aspect primordial de l'informatique. Le grand moment

pour la mémoire: quand on a finalement put accéder à une addresse

mémoire d'une façon non-cyclique, c'est-à-dire d'une façon dite aléatoire.

On en parle encore: voilà la Random Access Memory ou RAM de nos ordis.

* * *

Comment les données en mémoire sont-elles organisées. Le CC# 20

nous en donne un bref apperçu. C'est un peu étourdissant, chaque type de filière

réussit à traduire l'information en simple séquence de valeurs binaires.

Et l'information à propos de ce qui s'ensuit - metadata - permet de s'y retrouver.

si les données se retrouvent éparpillée, on peut les remettre en ordre: C'est

la défragmentation. Par contre, si on désire déménager une filière, on ne change

que l'information dans un directory. L'info se trouve toujours au même endroit.

Bien prope!